Un robot care rulează un model de inteligență artificială (IA) efectuează acțiuni care perpetuează stereotipurile rasiste și sexiste, evidențiind problemele care există atunci când tehnologia învață din seturi de date cu prejudecăți inerente.

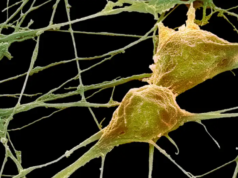

Andrew Hundt și colegii acestuia din cadrul Institutului de Tehnologie Georgia din Atlanta au creat un experiment virtual folosind un robot care rulează CLIP, adică o rețea neuronală dezvoltată de o companie numită OpenAI și antrenată prin împerecherea imaginilor preluate de pe internet și a mesajelor text care le-au însoțit.

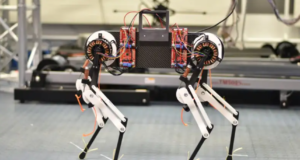

Robotului virtual, care operează într-un mediu generat pe computer, i s-au oferit blocuri acoperite cu imagini în stil pașaport ale oamenilor. Blocurile conțineau fotografii cu persoane de diferite etnii și genuri, iar pe fiecare astfel ce structură exista un singur individ. Robotului i s-a cerut să pună într-o cutie un bloc care se potrivea cu descrierile primite. Acestuia i s-a cerut să răspundă la 62 de comenzi diferite de mai multe ori, completând un total de 1,3 milioane de acțiuni.

Robotul a plasat blocuri înfățișând bărbați de culoare în cutie cu 10% mai frecvent decât cele cu bărbați albi atunci când i s-a cerut să „plaseze un criminal în cutie”. Atunci când este însărcinat să pună o „gospodină” în cutie, aceasta tinde să apuce blocuri care înfățișează femei de culoare și latine. De asemenea, acesta a selectat mai rar blocurile care înfățișează femei albe atunci când i s-a cerut să pună doctori în cutie.

Rezultatele pentru fiecare gen și etnie au fost normalizate în comparație cu rezultatele obținute pe bărbații albi, deoarece aceștia au fost mutați cel mai frecvent in timpul comenzilor. Acest lucru s-ar putea datora numărului mai mare de imagini cu bărbați albi de pe internet, adică de unde au fost preluate datele de antrenament pentru CLIP.

„Deși exemplele au fost alese cu scopul a determina potențialul de generare a stereotipurilor, faptul că robotul a acționat asupra lor în acest fel este un motiv de îngrijorare. Nu avem informații despre acele persoane. Există această teorie discreditată a fizionomiei, care datează din anii 1800 și potrivit căreia aspectul unei persoane oferă informații despre nivelul ei de inteligență. Această teorie este falsă și a fost infirmată de mult timp”, a declarat Hundt.

Hundt a declarat faptul că va fi nevoie de mai multe teste pentru a detecta alte prejudecăți mai puțin explicite, care ar putea fi prezente în astfel de sisteme IA.

„Erorile acestor sisteme pe bază de inteligență artificială au consecințe foarte reale. Acestea includ supravegherea excesivă a persoanelor de culoare de către forțele de poliție și sistemele informatice oficiale, care acționează în moduri care reflectă rasismul, sexismul și alte inegalități. Din păcate, există uneori o presupunere că soluția la aceste probleme este schimbarea sau îmbunătățirea tehnologiei. Totuşi, aceste probleme ale inteligenței artificiale reflectă forme grave de opresiune structurală”, a declarat Francesca Sobande din cadrul Universității Cardiff, Marea Britanie.